o1 مدل جدید هوش مصنوعی OpenAI با امکان «استدلال و منطق» میتواند به پرسشهای پیچیدهتری پاسخ دهد.

OpenAI مدل جدیدی به نام o1 را منتشر میکند که اولین مدل از سری مدلهای برنامهریزی شده “استدلال و منطق” این شرکت است و برای سریعتر از یک انسان پاسخ دادن به سؤالات پیچیدهتر، آموزش دیده است. این نسخه در کنار o1-mini، یک نسخه کوچکتر و ارزانتر، منتشر میشود. و اگر از شایعات مربوط به هوش مصنوعی مطلع هستید باید بگویم بله این در واقع همان مدل فوقالعاده و مورد انتظار Strawberry است.

برای OpenAI، مدل o1 در واقع گامی مهم به سوی هدف بزرگش؛ یعنی، هوش مصنوعی شبیه انسان است. اگر بخواهیم از تئوری و کاغذ فاصله بگیریم و اندکی کاربردیتر صحبت کنیم باید گفت برای مثال این مدل در نوشتن کدهای برنامهنویسی و حل مسائل چند مرحلهای بهتر از مدلهای قبلی کار میکند اما گرانتر و کندتر از GPT-4o نیز میباشد. OpenAI نسخه o1 را یک “پیشنمایش” معرفی میکند تا بر نوپا بودن آن تأکید داشته باشد.

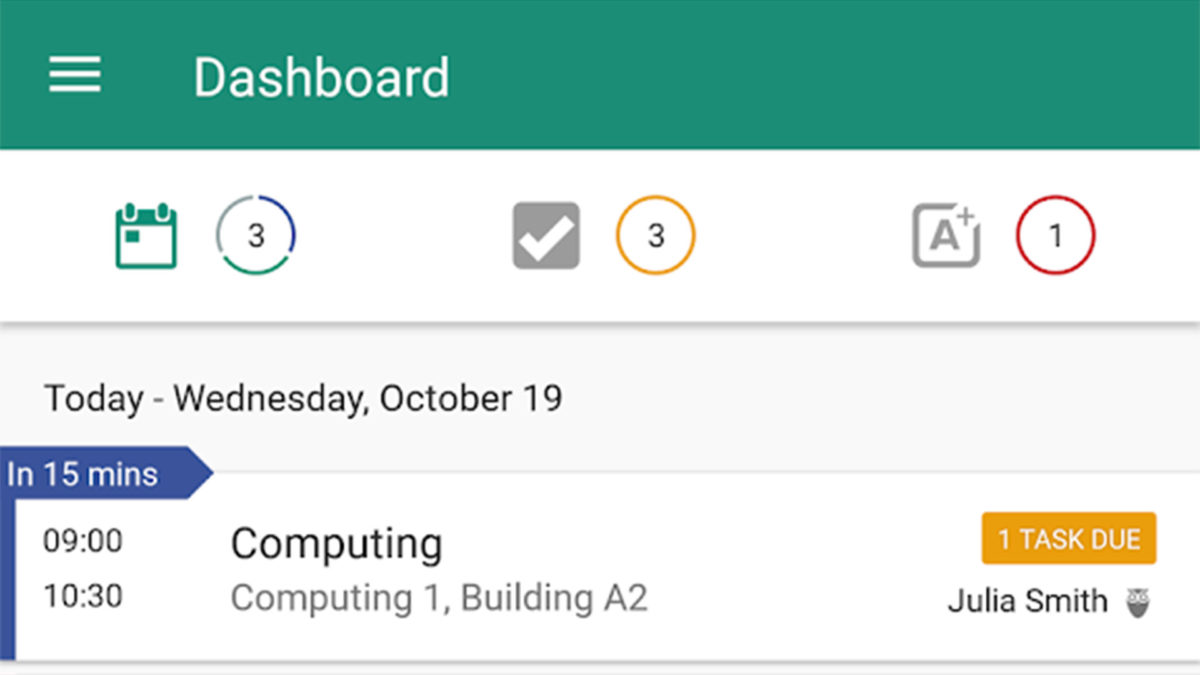

کاربران ChatGPT Plus و Team از امروز به o1-preview و o1-mini دسترسی خواهند داشت، در حالیکه کاربران Enterprise و Edu در اوایل هفته آینده به این مدلها دسترسی پیدا خواهند کرد. OpenAI قصد دارد دسترسی به o1-mini را برای همه کاربران رایگان ChatGPT فراهم کند البته هنوز تاریخ انتشار دقیقی را برای آن تعیین نکرده است.

استفاده توسعهدهندگان از o1 واقعاً هزینهبر است. در API مدل o1-preview کاربر باید به ازای هر یک میلیون توکن ورودی، یا تکههایی از متن تجزیه شده توسط مدل، ۱۵ دلار و به ازای هر یک میلیون توکن خروجی ۶۰ دلار بپردازد. برای مقایسه، در مدل GPT-4o این مبلغ ۵ دلار به ازای هر یک میلیون توکن ورودی و ۱۵ دلار به ازای هر یک میلیون توکن خروجی میباشد.

جری تورِک، سرپرست تحقیقات OpenAI، به رسانه اینترنتی ورج اطلاع داده است که آموزشهای o1 اساساً با نسخههای قبلیاش متفاوت است، اگرچه این شرکت در مورد جزئیات دقیق این آموزش چندان صریح صحبت نمیکند. او در ادامه گفت مدل o1 با استفاده از یک الگوریتم بهینهسازی کاملاً جدید و مجموعه دادههای آموزشی جدیدی که بهطور خاص برای آن طراحی شده، آموزش داده شده است.

به نقل از رسانه Vox، یک واقعیت نادیده گرفته شده در مورد مدلهای زبانی بزرگ (LLM)، این است که آنها در واقع پاسخهای زبانی «زنده» برای درخواستهای مختلف مخاطب خود تولید میکنند. شما برای آنها پرسش مطرح میکنید و آنها در پاسخ به آن شروع به صحبت میکنند و تا زمانی که کارشان تمام شود به صحبت کردن ادامه میدهند. در واقع این هوش مصنوعی نیست که به صورت خلاقانه و بدون نیاز به نیروی اولیه (پرسش) شروع به حرف زدن میکند بلکه مخاطب برای او یک سؤال مطرح میکند و صرفاً یک مونولوگ پس میگیرد.

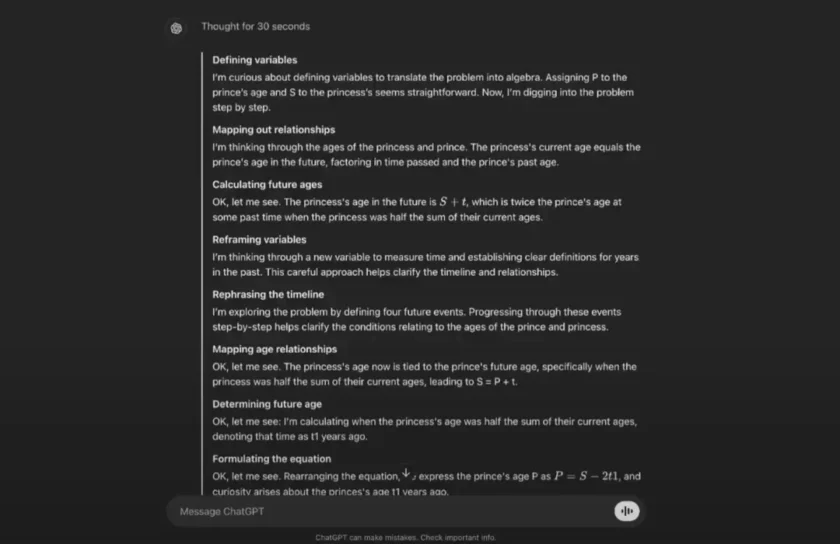

اگر به جملات و پاسخهای مدلهای فعلی نگاه کنید متوجه خواهید شد که جمله به جمله خود را بهبود میبخشند؛ از همین رو، این مدلها گاهی اوقات حتی در یک پاراگراف با خودشان تناقض دارند و ممکن است چیزی بگویند که بلافاصله عکس آن را دنبال کنند. مشکل اینجاست که گویا آنها با «صدای بلند» استدلال میکنند. اکنون در واقع به نظر میرسد OpenAI در مدل جدید o1 صدای این استدلال کردن را کمتر کرده است و چیزی تحت عنوان زنجیره افکار برای مدل هوش مصنوعی خود ایجاد کرده است (چیزی مشابه انسان برای استدلال کردن). بدین صورت هوش مصنوعی پیش از مطرح کردن نتایج افکارش ابتدا آن را در زنجیرههای مختلف افکار سبک سنگین میکند و راههای گوناگونی را برای رسیدن به پاسخ میپیماید و در نهایت پاسخهای دقیقتری را به کاربر ارائه میدهد.

OpenAI به مدلهای قبلی GPT آموزش داد تا الگوهای دادههای آموزشی آن را تقلید کنند. با o1، این مدل را آموزش داد تا به کمک تکنیکی به نام یادگیری تقویتی، که از طریق پاداش و جریمه به سیستم میآموزد، مسائل را به تنهایی حل کند. سپس مشابه با نحوه رویکرد انسان در مواجهه با مشکلاتش از یک “زنجیره فکر” برای پردازش پرس و جوها استفاده میکند.

با استفاده از این روش آموزشی جدید، OpenAI عقیده دارد که این مدل در پاسخ به پرسش کاربران و استفاده از تحلیل و منطق باید دقیقتر باشد.

ما متوجه شدهایم که این مدل کمتر توهم میزند اما مشکل همچنان پابرجاست و ما نمیتوانیم بگوییم که توهمات هوش مصنوعی را به کلی حل کردهایم.

جری تورک

به گفته OpenAI، اصلیترین چیزی که این مدل جدید را از GPT-4o متمایز میکند، استفاده از استدلال و منطق در پاسخگویی و همچنین توانایی آن در مقابله با مسائل پیچیده، مانند کدنویسی و ریاضی، بسیار بهتر از مدلهای قبلی این شرکت است.

در مسابقات برنامهنویسی آنلاین که با نام مسابقات Codeforces شناخته میشود، این مدل جدید به صدک ۸۹ شرکتکنندگان رسید و OpenAI ادعا میکند که بروزرسانی بعدی این مدل عملکردی مشابه با «دانشجویان دکتری در علوم چالشبرانگیز فیزیک، شیمی و زیستشناسی» خواهد داشت.

در عین حال، o1 در بسیاری از حوزهها به اندازه GPT-4o توانایی ندارد. در زمینه دانش واقعی درباره جهان به خوبی عمل نمیکند. همچنین امکان مرور وب یا پردازش فایلها و تصاویر را هم ندارد. با این حال، این شرکت معتقد است که یک کلاس کاملاً جدید از قابلیتها را هدف خود قرار داده است.

بخواهم صادق باشم؛ به نظرم ما در نامگذاری فاجعه هستیم. بنابراین با نامگذاری o1، امیدوارم یک گام معقولانه و رو به جلو در نامیدن محصولات خود برداشته باشیم و بدین صورت بتوانیم بهتر آنها را به جهان معرفی کنیم.

مکگرو

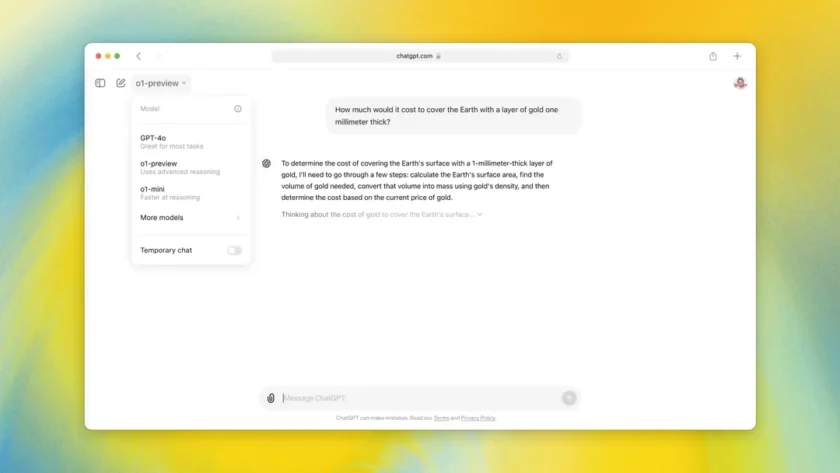

برای آزمایش مدل o1 یک معما را به عنوان نمونه پیش روی آن قرار دادند و خواستند تا پاسخ آن را بیابد. این مدل برای ۳۰ ثانیه به حالت انتظار رفت و سپس پاسخ صحیح را ارائه داد. OpenAI رابط کاربری این مدل را طوری طراحی کرده است تا مراحل استدلال آن را همانطور که این مدل فکر میکند، نشان دهد.

اما پرسشی که پیش میآید این است که این مدل در عمل دقیقاً چه فرقی با GPT-4o دارد. شما اگر همین سؤالات را از GPT-4o هم بپرسید احتمالاً به پاسخ صحیح برسید. هر چند OpenAI این مدل را طوری طراحی کرده است که در برابر سؤالات مطرح شده عباراتی مانند “من کنجکاو هستم”، “در حال فکر کردن هستم”، و “باشه، بگذار ببینم” را نمایش دهد و بدین صورت یک توهم گام به گام از تفکر کردن این مدل ایجاد کند.

حال اگر این مدل فکر نمیکند و دقیقاً مثل انسان نیست پس چرا اصلاً آن را طراحی کردید که این گونه به نظر برسد؟

بنا به گفته تورِک، OpenAI سعی در یکسانسازی نحوه فکر کردن هوش مصنوعی با شکل فکر کردن انسان ندارد و این رابط صرفاً قرار است نشان دهد که این مدل برای حل پرسشها، زمان بیشتری را صرف پردازش و درگیر شدن با مسائل میکند.

من حس میکنم چیزهای زیادی در مورد نحوه عملکرد این مدل وجود دارد که به شما احساس بیگانگی و عجیب بودن دست میدهد، اما در عین حال چیزهای زیادی هم وجود دارد که بهطور شگفتانگیزی احساس میکنید به نوعی با یک انسان طرف هستید!

مکگرو

به مدل زمان محدودی برای پردازش پرسوجوها داده میشود، بنابراین ممکن است چیزی شبیه این بگوید: «اوه، زمان تمام شده است، اجازه دهید سریع به یک پاسخ برسم.» در اوایل، در طول زنجیره فکری خود، شاید به نظر برسد که در حال مواجه شدن با یک طوفان افکار است و چیزی شبیه به “من میتوانم این کار را انجام دهم یا آن را انجام دهم، چه باید بکنم؟” را به معرض دید کاربر در میآورد و او را در فکر کردن خود دخیل کند و بدین شکل از او کمک بگیرد.

طراحی برای توسعه دهندگان

مدلهای زبانی بزرگ دقیقاً به آن اندازه که باید، هوشمند نیستند. آنها اساساً دنبالهای از کلمات را پیشبینی میکنند تا بر اساس الگوهایی که از حجم وسیعی از دادهها به دست میآیند، به شما پاسخ دهند.

همانطور که پیشتر هم گزارش شده بود، OpenAI به دنبال افزایش ۱۵۰ میلیارد دلاری بودجه تحقیقاتی خود میباشد. این شرکت قابلیتهای استدلالی را برای مدلهای زبانی خود به ارمغان خواهد آورد؛ زیرا، آینده را با سیستمها یا عوامل مستقلی میبیند که قادر به تصمیمگیری و انجام کارها از جانب شما هستند.

برای محققان هوش مصنوعی، دستیابی به استدلال گام بعدی مهم به سمت هوش در سطح انسانی است. تصور این است که اگر یک مدل توانایی بیش از تشخیص الگو را داشته باشد، میتواند در زمینههایی مانند پزشکی و مهندسی به پیشرفتهای بزرگی دست یابد. با این حال، در حال حاضر، تواناییهای استدلال o1 نسبتاً کند است، چندان عملگرا نیست و برای توسعه دهندگان گران است.

ما ماههای زیادی را بر روی توانایی استدلال کار کردهایم؛ زیرا، در واقع فکر میکنیم این یک پیشرفت مهم و حیاتی است. اساساً، این یک روش جدید برای مدلها است تا بتوانند مشکلات و مسائل واقعاً دشوار را که برای پیشرفت به سمت سطوح هوش انسانی، حل کنند.»

مکگرو