روز گذشته شرکت OpenAI از حالت صوتی پیشرفته به همراه صداهای بیشتر برای مدلهای هوش مصنوعی خود رونمایی کرد.

در جدیدترین اخبار حوزه هوش مصنوعی، OpenAI اعلام کرد که حالت صوتی پیشرفته (AVM) را در روز سهشنبه برای مجموعه گستردهای از مشتریان اشتراکی ChatGPT ارائه میکند. این حالت صوتی جدید، صحبت کردن با ChatGPT را طبیعیتر و انسانگونهتر میکند و در ابتدا برای مشتریان سطوح ChatGPT پلاس و Teams عرضه میشود. مشتریان Enterprise و Edu نیز هفته آینده دسترسی به این حالت را دریافت خواهند کرد.

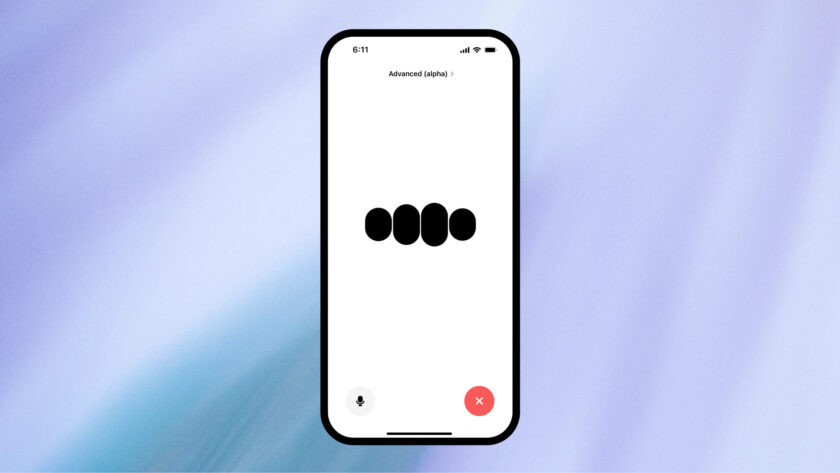

به عنوان قسمتی از این قابلیت جدید، این حالت صوتی پیشرفته، یک طراحی جدید و اصلاح شده نسبت به گذشته خواهد داشت. این حالت اکنون با یک کره آبی متحرک، به جای نقاط سیاه متحرک پیشین، نشان داده میشود.

حالت صوتی پیشرفته در طول هفته برای همه کاربران پلاس و Team در برنامه ChatGPT ارائه میشود.

در این مدت که شما صبورانه منتظر دستاوردهای جدید ما بودهاید، ما ستورالعملهای سفارشیشده، حافظه، پنج صدای جدید و لهجههای بهبود یافته را اضافه کردهایم.

هوش مصنوعی اکنون میتواند به بیش از ۵۰ زبان بگوید:«بابت تأخیر متأسفم.»

OpenAI

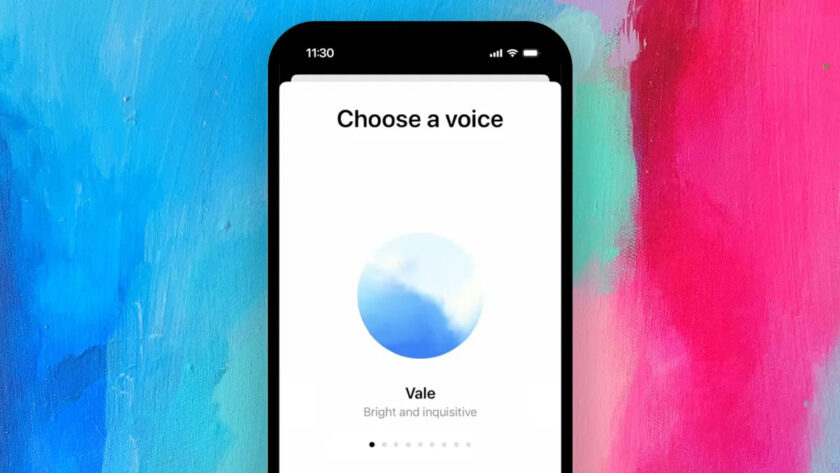

به نقل از خبرگزاری تِککرانچ، ChatGPT از این پس پنج صدای جدید نیز ارائه خواهد کرد که کاربران میتوانند آنها را امتحان کنند. این صداها عبارتند از Arbor، Maple، Sol، Spruce و Vale. با این کار تعداد کل صداهای ChatGPT در کنار Breeze، Juniper، Cove و Ember به ۹ عدد میرسد (تقریباً به اندازه Google’s Gemini Live). احتمالاً متوجه شدهاید که همه این نامها از طبیعت الهام گرفته شدهاند؛ دلیل آن احتمالاً هدف OpenAI در طبیعیتر کردن ChatGPT باشد.

یکی از صدایی که در این مجموعه وجود ندارد، Sky است؛ صدایی که OpenAI در بروز رسانی بهار خود آن را به نمایش گذاشت و منجر به شکایت قانونی اسکارلت جوهانسون از این شرکت شد. این بازیگر که در فیلم سینمایی “Her” نقش یک سیستم هوش مصنوعی را بازی کرده بود، ادعا میکرد صدای اسکای کمی شبیه صدای خودش است. OpenAI به سرعت صدای Sky را کنار گذاشت و علیرغم اینکه در آن زمان چندین کارمند در توییتهایی به مشابهت Sky با فیلم Her اشاره میکردند، OpenAI اعلام کرد هرگز قصد شبیه سازی و تقلید از صدای جوهانسون را نداشته است.

یکی دیگر از ویژگیهایی که در این بروزرسانی وجود ندارد، اشتراکگذاری ویدیو و صفحه نمایش ChatGPT است که OpenAI چهار ماه پیش در مراسم معارفه بهار خود از آن رونمایی کرده بود. این ویژگی قرار است به GPT-4o اجازه دهد تا اطلاعات دیداری و شنیداری را به طور همزمان پردازش کند. در طول نمایش آزمایشی این ویژگی، یکی از کارکنان OpenAI نشان داد که چگونه میتوانید لحظه به لحظه از ChatGPT سؤالات ریاضی را بر روی یک تکه کاغذ در مقابل خود یا کد روی صفحه رایانه بپرسید. در حال حاضر، OpenAI جدول زمانی دقیقی را برای راهاندازی این قابلیتهای چندوجهی ارائه نداده است.

گفته میشود، OpenAI از زمان انتشار تست آلفای این حالت صوتی پیشرفته، بهینهسازیهایی را بر روی آن اِعمال کرده است؛ ظاهراً قابلیت صوتی ChatGPT اکنون در درک لهجهها بهتر عمل میکند و این شرکت میگوید مکالمات آن نیز روانتر و سریعتر شده است. در طول آزمایشهایمان با این قابلیت، متوجه شدیم که باگهای نرمافزاری چندان غیرمعمول هم نیستند اما این شرکت ادعا میکند که اکنون این باگها برطرف شدهاند.

OpenAI همچنین برخی از قابلیتهای سفارشیسازی ChatGPT را به این حالت صوتی گسترش میدهد؛ دستورالعملهای سفارشی، که به کاربران اجازه میدهد نحوه پاسخدهی ChatGPT به آنها را شخصیسازی کنند و حافظه، که به ChatGPT اجازه میدهد تا مکالمات را به خاطر بسپارد و بعداً به آنها ارجاع دهد.

یکی از سخنگویان OpenAI میگوید حالت صوتی پیشرفته هنوز در چندین منطقه از جمله اتحادیه اروپا، بریتانیا، سوئیس، ایسلند، نروژ و لیختن اشتاین در دسترس نیست.